Durante años, la industria de la inteligencia artificial ha estado dominada por una idea casi incuestionable: “cuanto más grande sea el modelo, mejor será su rendimiento”. Gigantes como OpenAI, Google y Anthropic han invertido miles de millones de dólares en la creación de modelos con cientos de miles de millones de parámetros, buscando alcanzar mayores niveles de razonamiento, comprensión y generación de lenguaje. Sin embargo, un nuevo desarrollo de Samsung ha puesto en entredicho esa premisa.

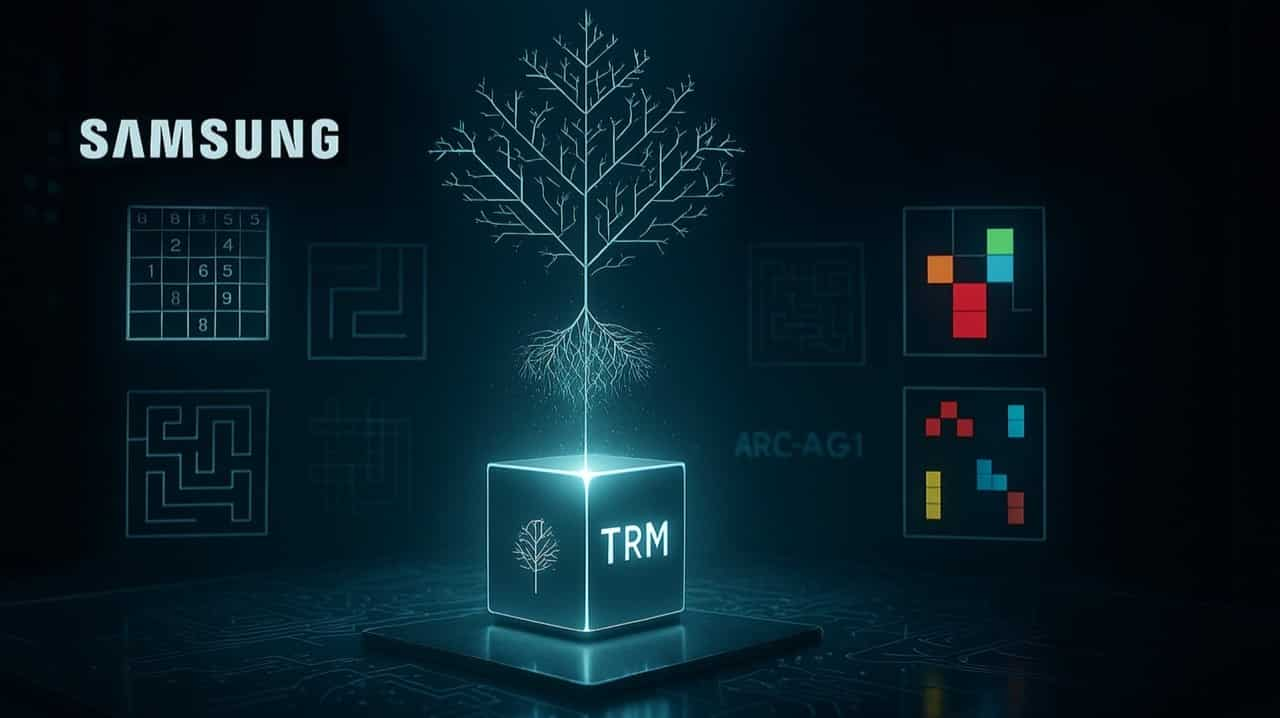

Desde su laboratorio de inteligencia artificial en Montreal, un pequeño equipo de investigadores ha presentado el Tiny Recursive Model (TRM), un modelo radicalmente distinto a los LLM tradicionales. Lejos de apostar por la escala, TRM es 10.000 veces más pequeño que los modelos más avanzados del mercado, con apenas siete millones de parámetros, y aun así logra resultados de razonamiento comparables —e incluso superiores— a sistemas miles de veces más grandes.

Samsung ha liberado TRM como código abierto en GitHub, junto con un artículo científico disponible en arXiv, en el que explica su innovador enfoque: una arquitectura recursiva que permite al modelo mejorar sus propias respuestas con cada iteración. En lugar de depender de una red neuronal gigantesca, TRM se centra en refinar sus salidas a través de un proceso de retroalimentación interna.

Un modelo pequeño, pero sorprendentemente potente

De acuerdo con las pruebas reportadas, el TRM superó a modelos colosales como DeepSeek R1 (671.000 millones de parámetros), Gemini 2.5 Pro y o3-mini en el exigente benchmark ARC-AGI, diseñado para evaluar la capacidad real de razonamiento de una IA.

Los resultados fueron notables:

- 44,6% de precisión en ARC-AGI-1.

- 7,8% en ARC-AGI-2, donde la mayoría de los modelos apenas superan el 5%.

- 87% en Sudoku-Extreme, una prueba que evalúa la resolución de problemas de tipo humano.

Lo más llamativo es que todo esto se logra con un modelo tan liviano que puede ejecutarse en una laptop común, lo que abre posibilidades enormes en términos de accesibilidad y eficiencia energética.

¿Qué significa un enfoque recursivo?

El principio de la recursividad puede resumirse con una pregunta simple: “¿Mi respuesta es buena? Si no lo es, ¿puedo mejorarla?”

TRM no se limita a generar una única respuesta. En cambio, produce una versión inicial, la evalúa, y luego la mejora sucesivamente hasta alcanzar un nivel óptimo de coherencia o precisión.

Este proceso de “pensar sobre su propio pensamiento” permite que incluso una red pequeña aprenda a razonar sin requerir una cantidad descomunal de datos o parámetros.

En el pasado, modelos como el Hierarchical Reasoning Model (HRM) habían intentado incorporar pensamiento recursivo, pero con estructuras complejas y dependientes de teorías matemáticas o biológicas difíciles de interpretar. TRM, en cambio, simplifica el proceso al utilizar una sola red ligera, guiada únicamente por el aprendizaje mediante prueba y error.

Un cambio de paradigma en la IA

El mayor aporte del Tiny Recursive Model no está solo en su eficiencia técnica, sino en el mensaje que envía al ecosistema de la inteligencia artificial: el futuro no tiene por qué depender de modelos gigantescos.

TRM demuestra que la inteligencia no siempre está en la escala, sino en la estrategia. Que un modelo pequeño, si está diseñado para pensar de manera recursiva, puede igualar —o incluso superar— el razonamiento de los titanes de la IA.

En un mundo donde entrenar modelos cada vez más grandes se traduce en costos multimillonarios y huellas de carbono masivas, la propuesta de Samsung apunta a una nueva era de IA más inteligente, sostenible y accesible.

Con TRM, el gigante surcoreano no solo ha sorprendido a la comunidad tecnológica, sino que ha abierto la puerta a un futuro donde “más pequeño” podría, por fin, significar “mejor”..